在 AlphaGo 席卷棋坛、GPT-4 改写语言边界之后,OpenAI 研究员 Shunyu Yao 抛出一个颠覆式观点:真正决定 AI 未来的,已不再是「训练出多强的模型」,而是「该让模型解决什么样的问题、如何衡量真实效用」。他亲历从 Deep RL 的挫折到 o-series 推理模型的诞生,在这篇文章中首次系统梳理「上半场」方法至上、基准次要的旧范式如何被「先验+推理+通用 RL 配方」彻底改写,并揭示「下半场」评估革新的新战场。若你想了解为什么下一个突破口不在更大模型,而在重新设计任务与评价——这篇就是值得你细读的路线图。

更有趣的是,评论区的讨论进一步印证了作者对「从刷榜到创造价值」这一重大转变的预判。许多读者从自己的研究经历或工作场景出发,呼应了文中对「效用问题」的剖析:即单纯打破考试或游戏的极限并不等于经济和社会层面的落地。其中,一些评论者建议「互补式 AI」才是现实所需,把智能体真正融入人类的工作流与日常决策,更强调大模型的常识与上下文推理。也有人从「first principles thinking」切入,探讨如何借助知识图谱和语言模型来挖掘隐性假设,并在科研和工程中打开新思路。更具争议的部分在于 RL 和先验的重要性,有读者引用 Sutton、Silver 等人的观点,质疑或呼应「先验大于环境、算法」的结论,并以围棋、股票交易和长时记忆等领域作为案例,展示在不同环境下,RL 的表现和价值评估尺度或许各异。这些多元化的反馈不仅佐证了作者对于「下半场」发展脉络的洞察,也凸显了学界与业界对「重新定义问题与评估方式」的热烈需求。

原文标题:《The Second Half》,译文初稿由 o3 翻译。

作者:Shunyu Yao(姚顺雨),Researcher of OpenAI

数十年来,人工智能(AI)的核心始终是发明新的训练方法与模型。这条路径屡试不爽:从在国际象棋与围棋上击败世界冠军、在 SAT 与律师资格考试上超越大多数人,到在 IMO 与 IOI 夺得金牌。载入史册的里程碑——DeepBlue、AlphaGo、GPT‑4 与 o‑series——背后分别是搜索、深度强化学习(RL)、大规模化以及推理等方法上的根本性创新。时间推移,一切都在不断变好。

那么,现在究竟突然发生了什么改变?

用三个词概括:强化学习终于奏效。更准确地说:强化学习终于实现了泛化。经历多次弯路与一连串里程碑后,我们找到了通用配方,能够用语言与推理解决广泛的 RL 任务。哪怕在一年前,若你告诉大多数 AI 研究者:单一配方可同时攻克软件工程、创意写作、IMO 级数学、鼠标键盘操控和长篇问答——他们会笑称你在「幻觉」。这些任务都极其困难,许多研究者甚至用整个博士阶段只聚焦于其中狭小一片。

然而,它真的发生了。

接下来会怎样?AI 的「下半场」——从现在开始——将从「如何解决问题」转向「应当定义什么问题」。在这一新时代,评估比训练更为关键。我们不再仅仅问「能否训练模型解决 X?」而要问「我们应该让 AI 做什么,以及如何度量真正的进展?」要在下半场中脱颖而出,我们需要及时地转变心态与技能,更像一名产品经理。

上半场

想理解上半场,就看谁是赢家。哪些被认为是最有影响力的 AI 论文?

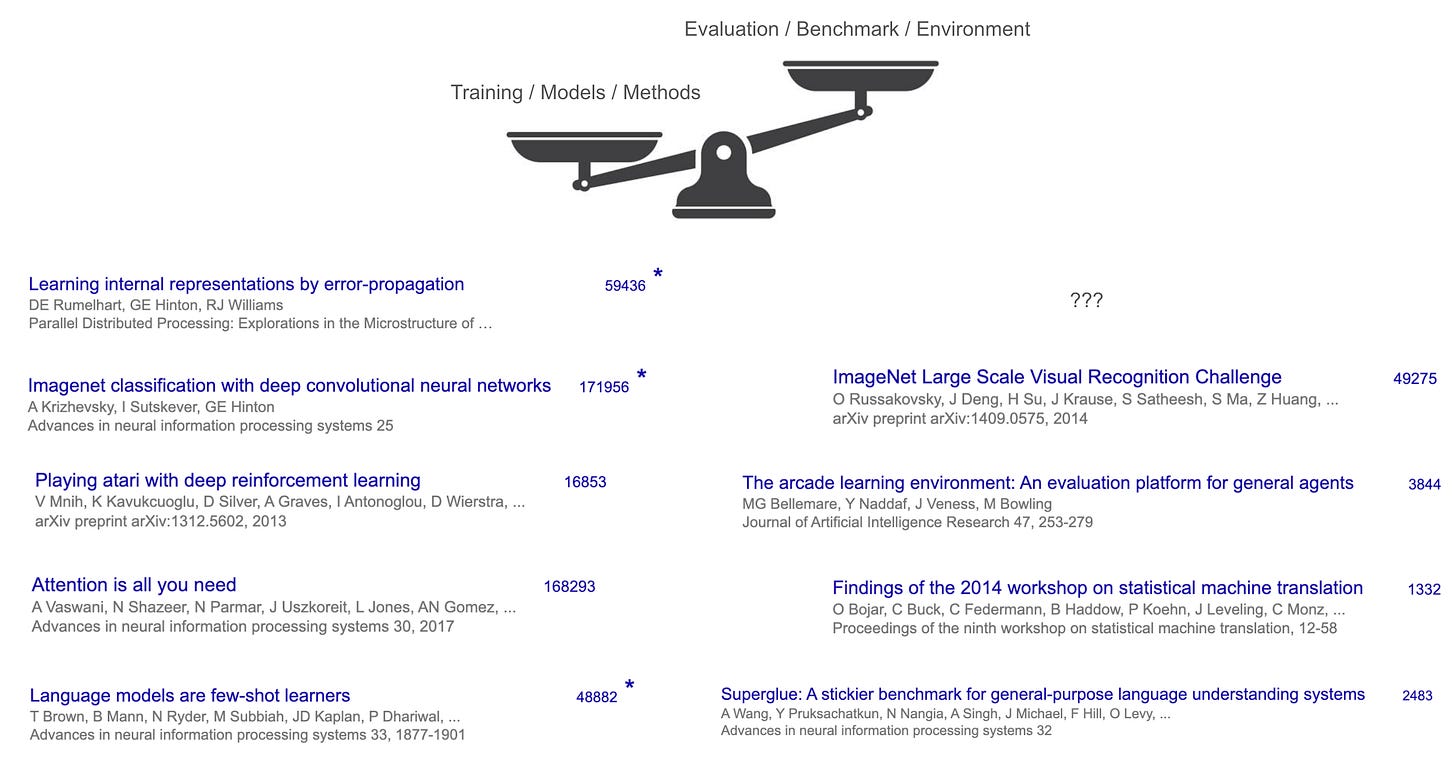

我在斯坦福 224N 课上做过小测,答案并不意外:Transformer、AlexNet、GPT‑3 等。它们有什么共同点?提出了能训练出更好模型的根本性突破;同时,它们通过在某些基准上取得显著提升,得以发表。

但还有隐含共性:这些「赢家」都是训练方法或模型,而非基准或任务。就算是被誉为最具影响力的基准 ImageNet,其引用量也不到 AlexNet 的三分之一。在 Transformer 的案例中,这种反差更为极端——Transformer 的核心基准是 WMT’14,相关研讨会报告约 1,300 次引用,而 Transformer 论文已超 160,000 次。

这揭示了上半场的游戏规则:专注构建新模型与方法,评估与基准只是配角(但对论文体系仍属必要)。

为什么?因为在上半场,方法比任务更难也更令人兴奋。从零设计新算法或架构——例如反向传播、卷积网络(AlexNet)或 GPT‑3 所用的 Transformer——需要非凡的洞见与工程;相比之下,为 AI 定义任务常常更直观:把人类已有的任务(翻译、图像识别、下棋)转成基准即可,几乎不需太多洞见与工程。

方法也往往更通用、更具广泛适用性。Transformer 架构最终推动了计算机视觉、自然语言处理、强化学习等多个领域的进展,远超其首次证明价值的单一数据集(WMT’14 翻译)。伟大的新方法能在许多基准上取得突破,因为它简单、通用,其影响超越单一任务。

这一套游戏行之数十年,激发了改变世界的创意与突破,并体现在各领域基准的不断刷新。那么为何游戏会改变?因为这些想法与突破的累积,让我们得以创出「通用配方」来解决任务。

配方

那这份配方是什么?它的原料并不意外:海量语言预训练、规模(数据与算力)以及推理与行动的概念。这些词在旧金山每天都听得到,但为何把它们称为「配方」?

从强化学习视角观之(RL 常被视作 AI 的「终局」——理论上可在游戏中取胜,且像 AlphaGo 这样的超人系统也离不开 RL),RL 有三大核心:算法、环境与先验。

长期以来,RL 研究者主要聚焦算法(如 REINFORCE、DQN、TD‑learning、Actor‑Critic、PPO、TRPO…),把环境与先验视作固定不变或最简化。例如 Sutton & Barto 的经典教材几乎满篇算法,环境与先验着墨甚少。

然而在深度 RL 时代,环境的重要性在经验上被放大:算法表现常高度依赖其开发与测试时所处的环境。若忽视环境,你可能打造出只在玩具问题上卓越的「最优」算法。那我们为何不先弄清真正想解决的环境,再找最合适的算法?

OpenAI 的初衷正是如此。团队先做了 Gym,打造多款游戏的统一 RL 环境;随后是 World of Bits 与 Universe,试图把互联网或电脑变成一个大游戏。听上去很棒:一旦把数字世界转成环境,再用聪明 RL 算法攻克,就能得到数字 AGI。

好计划,却未完全成功。OpenAI 依赖 RL 取得了巨大突破(如Dota、机械手解魔方),但从未真正解决电脑操作或网页导航,且一个领域的 RL 代理难以迁移到另一领域。缺了什么?

直到 GPT‑2、GPT‑3 之后,谜底揭晓:缺的是先验。需要强大的语言预训练,把常识与语言知识蒸馏进模型,再微调为 WebGPT 或 ChatGPT(进而改变世界)。结果表明,RL 最重要的部分或许根本不是算法或环境,而是完全可独立于 RL 获得的「先验」。

语言预训练为对话提供了良好先验,但对电脑控制或视频游戏却一般。原因是这些领域与互联网文本分布更远,直接做 SFT/RL 泛化效果差。我在 2019 年注意到这一点——那时 GPT‑2 刚问世,我用其做 SFT/RL 来攻克文字冒险游戏;CALM 是世界首个基于预训练语言模型构建的代理。然而它需要数百万 RL 步才能在单个游戏上爬坡,且无法迁移到新游戏。虽说这正是 RL 的常态,但我觉得奇怪:人类能轻松零样本玩新游戏并表现更好。随后,我迎来人生第一次「顿悟」——人类能泛化,是因为我们不只会执行「去柜子 2」「用钥匙 1 开箱子 3」「用剑杀地牢」,还会选择「思考」:「地牢危险,需要武器。看不到武器,也许要去锁着的箱子找。箱子 3 在柜子 2,那就先过去开箱子。」

「思考」或「推理」是一种奇特的动作——它不直接影响外部世界,却拥有开放式、组合爆炸的空间:你可以思考一个词、一句话、一段文字,甚至 10,000 个随机英文单词,而外部世界不会立刻改变。在经典 RL 理论里,这交易极差:若需从两个箱子里选,一个有 100 万美元、一个空,你期望收益 50 万;若我再加无限个空箱,你期望收益瞬间归零。但在任何 RL 环境中把「推理」加入动作空间,我们得以利用语言预训练提供的先验来泛化,并依据不同决策灵活分配测试时算力。这真是魔法般的事情——若要完整阐释,我得另写一篇博客;可参考 ReAct 了解推理型代理的初始故事。直觉解释:虽然你额外加入了无尽空箱,但你在各种游戏里见过它们,选择这些箱子的经历反而让你在任何游戏中更可能选对有钱箱。抽象解释:语言通过代理中的推理实现泛化。

一旦拥有合适的 RL 先验(语言预训练)和 RL 环境(把语言推理加入动作),RL 算法反而成了最琐碎部分。于是诞生了 o‑series、R1、Deep Research、电脑使用代理等等,还远未到尽头。讽刺的是:RL 研究者长期把算法看得比环境重要,无人关心先验——几乎所有 RL 实验都是「从零开始」。但我们花了几十年绕路才发现,也许真正的优先级应完全相反。

但正如 Steve Jobs 所说:只有回顾时,才能串起那些点。

下半场

这份配方正在彻底改写游戏规则。回顾上半场的游戏:

开发新训练方法或模型,在基准上爬坡。

创造更难的基准,然后循环。

如今这套玩法正在被「毁掉」,原因在于:

这份配方已把「爬基准」工业化、标准化,且无需太多新创意。配方具备规模化与良好泛化——你的新方法或许能提升 5%,而下一代 o‑series 未对准任务却能提升 30%。

即便我们打造更难基准,它们很快(且越来越快)就被配方攻克。同事 Jason Wei 画了张图,生动展示了这一趋势:

那么,下半场还剩什么可玩?如果新方法不再稀缺、难基准也会迅速被破,那我们该怎么办?

我认为,必须从根本上重新思考「评估」。不仅是创建新、更难基准,而是质疑现有评估「设定」,并创建全新的设定,迫使我们发明超越配方的新方法。这很难,因为人类有惯性,极少质疑基本假设——你把它们当自然法则,而忘了它们只是「假设」。

谈惯性:假设你在 2021 年发明了史上最成功的基于人类考试的评测之一。那在当时非常大胆,但三年后已被「刷爆」。你会怎么做?大概率是再造一个更难的考试。又或许你攻克了简单编程任务,接着会找更难的编程任务——直到达到 IOI 金牌水平。

惯性无可厚非,但问题在于:AI 已在国际象棋与围棋击败世界冠军,在 SAT 与律师资格考试中超过大多数人,并达到 IOI/IMO 金牌水平,可世界(至少从经济与 GDP 视角)并未随之巨变。

我称之为「效用问题」(utility problem),并认为它是 AI 的最关键课题。

或许我们很快就能解决「效用问题」,也可能不会。无论如何,根本原因或许出奇简单:我们的评估设定在很多基本方面与现实世界不同。举两例:

评估「理应」自动运行:通常代理收到任务输入、自动执行、得到奖励。但现实里,代理必须在任务过程中持续与人类互动——你不会一次性发给客服超长信息,等 10 分钟就期待对方把一切解决。因此,有人质疑这一设定,发明了要么让真人参与(如 Chatbot Arena),要么引入用户模拟(如 tau‑bench)的新基准。

评估「理应」独立同分布(i.i.d.):若测试集有 500 个任务,就独立运行、取平均。但现实中,你会按序列解决任务。谷歌软件工程师随着熟悉代码库,修复 bug 越来越快;而代理在同一仓库却无法积累经验。显然我们需要长期记忆方法(已有不少 研究),可学界缺乏相应基准,也缺乏质疑 i.i.d. 假设的勇气——它一直是机器学习的基石。

这些假设「向来」如此;在上半场,基于这些假设开发基准完全没问题,因为当智能水平较低时,提高智能通常能提升效用。但现在,通用配方已在这些假设下「稳赢」。因此,下半场的新玩法是:

开发面向真实效用的新评估设定或任务。

用配方(或配方增强)来攻克它们,然后循环。

这游戏既陌生又困难,却令人振奋。上半场玩家解决视频游戏与考试;下半场玩家则能凭「把智能变产品」打造数十亿甚至万亿美元的公司。上半场充斥渐进式方法与模型;下半场,通用配方会「碾压」这些渐进式进展,除非你创建全新假设,迫使人们发明真正改变游戏的研究。

欢迎来到下半场!

致谢

本文基于我在 Stanford 224N 与 Columbia 的讲座。初稿由 OpenAI Deep Research 阅读我的幻灯片并撰写。

写于 2025 年 4 月 10 日