OpenAI GPT-4o 图像生成模型架构研究:自回归+扩散

深度融合于 4o 模型内部,通过顺序生成图像 token 来实现对视觉的精确控制 。社区专家推测,其内部可能包含自回归先验和扩散/VAE解码相结合的混合架构,以兼顾生成质量与模型集成 。

官方信息:GPT-4o 图像生成模型的实现方式与架构设计

多模态统一与自回归生成: OpenAI于2025年3月推出的「GPT-4o 图像生成」功能被描述为「原生嵌入」在GPT-4o多模态模型中的能力 。GPT-4o 不同于以往的DALL·E系列扩散模型,OpenAI官方明确指出GPT-4o采用「自回归(autoregressive)」架构来生成图像 。也就是说,图像是按顺序逐步生成的,而非一次性通过扩散反复噪声退火得到。GPT-4o在训练时使用了海量的图文联合数据,使模型学习图像与文本的联合分布,从而具备将文本与视觉信息深度融合的能力 。OpenAI将这一模型称为「原生多模态」GPT-4o 模型,能够利用其内部知识和对话上下文来指导图像生成 。

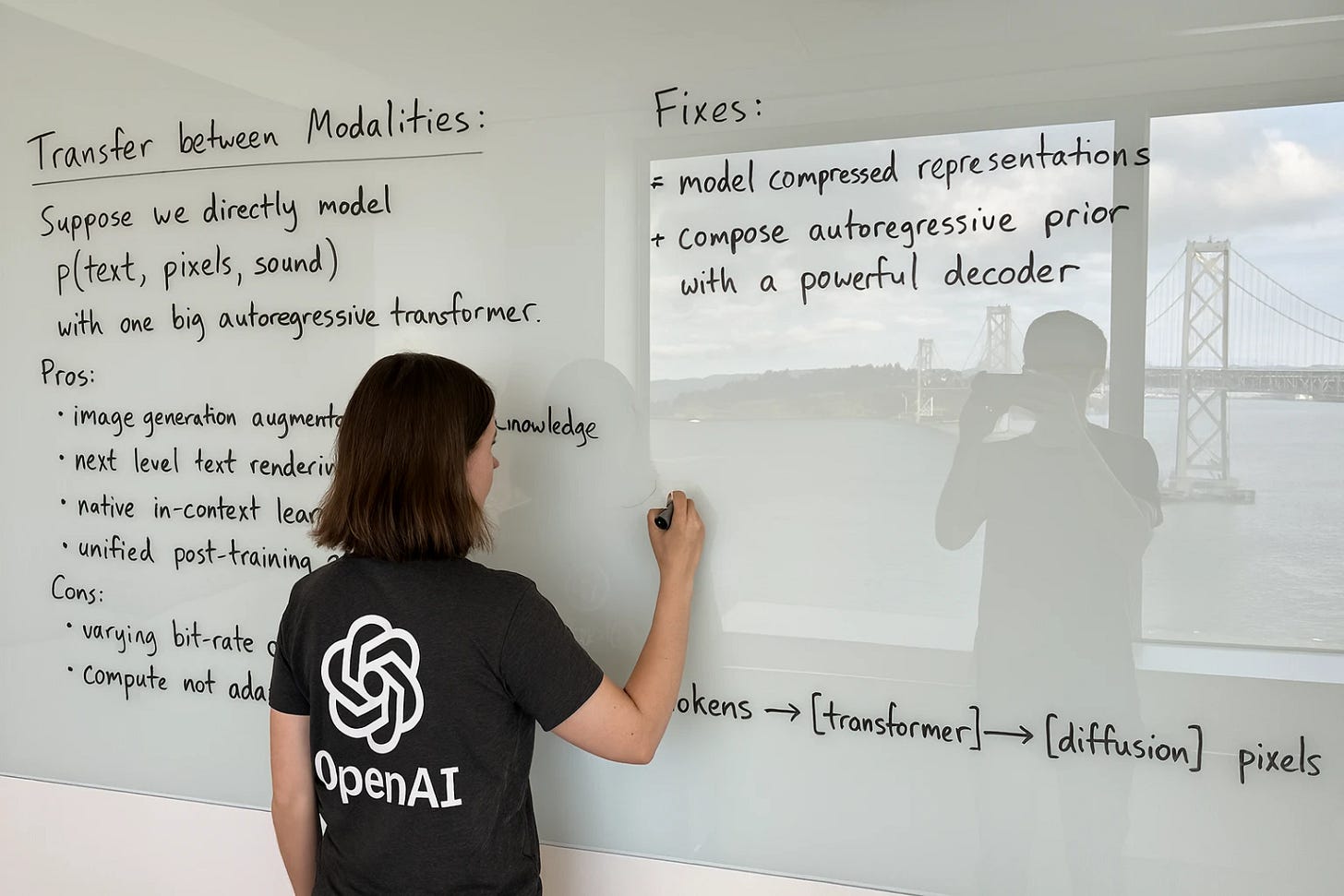

OpenAI内部关于多模态架构的白板方案:左侧探讨了用单一大型Transformer直接生成图像(自回归)的方案及其优缺点;右侧给出的改进是采用「自回归先验+强力解码器」策略,并在底部画出架构示意「tokens -> [transformer] -> [diffusion] -> pixels」 。这一构想预示GPT-4o可能先由Transformer产生压缩图像表示,再经由扩散模型解码得到像素图像。

架构核心与技术细节: 上述白板思路表明,GPT-4o图像生成架构由两部分组成:首先是一个Transformer模型根据文本等输入生成某种压缩的图像表示(类似潜编码或隐藏向量);然后一个强大的解码器将该表示转换为最终图像 。OpenAI官方虽未在博客中详解该解码器的形式,但在系统卡中强调「4o图像生成是一种自回归模型」 。因此可以推测Transformer输出的图像表示是离散token序列,模型逐token地自回归生成图像信息,直至构成完整图像。这种逐步生成方式类似于语言模型逐字生成句子,也使模型能够精确地将文字嵌入图像中指定的位置 。GPT-4o经过针对图像生成任务的强化后训练和调优,具备了比DALL·E更高的视觉流畅度和一致性 。例如,它能够生成包含清晰可读文字的图像(如路牌、菜单等),严格遵循复杂的用户指令,并利用对话历史和自身知识进行上下文感知的创作 。值得一提的是,OpenAI研究团队通过人类反馈强化学习对模型进行了打磨。据报导,OpenAI聘请了100多名人工标注者针对模型生成的图像瑕疵(如拼写错误、手部扭曲等)提供反馈,用以强化训练模型改善这些细节 。这一系列官方设计和训练策略使GPT-4o成为OpenAI迄今最强大的图像生成模型,在架构上实现了语言和图像生成的深度融合。

专家与社区对模型架构的分析与推测

GPT-4o的发布在AI研究者和开发者社区引发了热烈讨论,很多人试图推测其底层架构究竟是纯自回归生成、扩散模型,亦或二者的结合。普遍共识是:GPT-4o 舍弃了传统纯扩散模型逐帧成像的方案,转而采用逐token生成图像的自回归方式 。用户也直观观察到,在ChatGPT界面生成图像时,图像往往自上而下逐行清晰地显现出来,这与模型按序生成图像内容的机制是一致的 。正如OpenAI研究负责人Gabriel Goh所解释的那样,GPT-4o是从左上角开始像写字一样绘制图像,这一技术差异可能正是其文本渲染和属性绑定能力优于扩散模型的原因 。

有社区专家据此指出,GPT-4o并非调用一个独立的图像模型,而是完全融合在GPT-4o大型模型内部,通过输出图像token来直接「画图」 。

然而,对于GPT-4o背后是否仍涉及扩散模型,专家们提出了不同见解和推测:一派观点认为GPT-4o架构实为「自回归+扩散的混合」模式——GPT-4o的Transformer先生成高层图像表征(可能是类似CLIP图像嵌入、多尺度latent等向量),然后再交由一个扩散模型解码器将该表征还原为完整图像 。换言之,GPT-4o充当了autoregressive先验,输出对图像的压缩描述,随后一个大型扩散模型以此为条件进行高分辨率图像合成。这种推测引用了近期多模态模型的思路,例如Würstchen等研究展示了高度压缩的图像潜编码与最终图像有很强的相关性,因而可以先让语言模型生成这种潜编码,再由扩散模型解码 。据推测,这也解释了为何ChatGPT生成图像时会先快速出现一个模糊预览,然后逐步细化为清晰图像——模糊预览对应快速生成的粗略图像latent解码,而细节则由后续扩散迭代完善 。

另一派观点则认为GPT-4o完全通过自回归Transformer生成离散图像tokens,并使用事先训练好的VQ-VAE(向量量化自动编码器)将token序列解码回图像 。支持这一观点的专家指出,GPT-4o生成的成品图像中仍可见类似VAE压缩导致的细微伪影 (例如局部纹理的不连续感),这暗示模型可能采用了有损的离散代码表示图像,而这正是VQ-VAE+Transformer方案的典型迹象。总的来说,社区普遍认可GPT-4o采用了前所未有的大模型多模态训练和新颖的生成流程:利用GPT-4o强大的语言Transformer来理解复杂指令并规划图像布局,再通过专门的生成模块(不管是内置的自回归像素生成亦或辅助解码器)来绘制高保真图像 。这种架构上的创新被认为是GPT-4o能够精细地遵循长复杂提示、正确拼写并排版文本以及绑定多个对象属性的关键 。代价则是生成速度相对较慢——相比DALL·E一次输出多张图,GPT-4o逐token绘制一张高细节图像往往需要数十秒时间 。OpenAI团队认为这在可接受范围内,并表示随着优化进展,未来有望进一步降低延迟 。社区也注意到这种逐步生成允许流式预览,在等待过程中逐行看到图像成型,这提高了交互体验 。综合来看,AI 社区对GPT-4o架构的推测可概括为:GPT-4o以LLM为大脑驱动图像创作,底层可能结合了离散表示和扩散/解码技术,以实现远超以往模型的生成品质。

演进对比:GPT-4o与DALL·E 2/3等前代模型差异

GPT-4o的推出标志着OpenAI图像生成模型的一次重要架构跃迁。与前代的DALL·E系列模型相比,GPT-4o在技术实现和能力上都有显著不同:

• 生成机制对比: DALL·E 2(2022年发布)采用了层次化扩散模型架构。它首先通过CLIP模型将文本编码为向量,再利用扩散模型prior从文本嵌入生成对应的图像latent,最后通过扩散解码器将latent逐步解码成图像 。整个过程属于扩散模型范式,图像是通过对噪声迭代净化生成的。DALL·E 3(2023年发布)在底层依然沿用了扩散生成策略,只是在模型训练和使用上更强调与ChatGPT的集成,以改善对复杂提示的遵循。但无论DALL·E 2还是3,其图像生成模块本质上都是独立于GPT语言模型之外的扩散模型 。相比之下,GPT-4o在架构上舍弃了扩散模型独立生成整张图像的方式,转而采用自回归生成 。正如OpenAI所述,GPT-4o是通过从左到右、从上到下地顺序绘制来产出图像,这类似于人类书写文字的过程 。这种自回归生成机制使GPT-4o能够在输出过程中灵活地融入文本符号和细节,并确保生成过程与文本语义保持严格对应。简而言之,DALL·E系列属于「扩散模型并行生成像素」,而GPT-4o则转向「自回归模型逐序绘制图像」 。

• 模型集成与上下文理解: 先前的DALL·E模型虽然在ChatGPT中提供了插件式接入(例如ChatGPT调用DALL·E 3生成图片),但它们与语言模型是分离的,缺乏共享的记忆和上下文 。用户往往需要在不同模式间切换,生成图片后如需修改也只能重新描述提示,无法像对话那样逐步细化 。GPT-4o则将图像生成深度融合进ChatGPT中,成为GPT-4o模型天然的一部分 。这意味着GPT-4o在同一对话上下文中同时理解此前的文本交流、用户上传的图像等,并据此影响新的图像创作 。例如,GPT-4o可以记住对话中用户提及的设定或提供的示例图,在后续生成时保持风格和内容的一致。这种多轮交互与记忆能力是DALL·E 3所不具备的 。集成上的演进使GPT-4o更像一个真正的「会画画的ChatGPT」,而非一个外接的绘图工具。

• 文本渲染与复杂指令执行: 文本内容是评估图像生成模型的重要难题。DALL·E 2 和 3 经常无法正确地在图像中嵌入文字,生成的文字往往是乱码或拼写错误,这在标志、海报等任务中非常明显 。GPT-4o在这方面有了飞跃的提升。得益于自回归架构和多模态训练,GPT-4o可以在图像中产生清晰、可读且布局准确的文本 。OpenAI官方示例展示了GPT-4o生成的街道路牌、菜单、邀请函等,其中的文字几乎完美呈现 。研究负责人指出,这是由于GPT-4o从架构上让图像和文本「说同一种语言」,模型能对文字内容进行像素级规划和绘制 。此外,在复杂场景和长指令的处理上,GPT-4o也远胜前代模型。DALL·E 2/3通常在同时包含5-8个元素的提示下就开始混乱,出现颜色、形状对应错误等绑定问题 ;GPT-4o则通过更强的上下文理解和规划,可以准确地遵循包含15-20个元素的复杂描述,保证每个对象的属性和位置都符合要求 。这种大幅提升源于GPT-4o在训练中强化了属性绑定能力,以及其利用世界知识进行推理的能力 。例如,让模型绘制「红色三角形和蓝色星星」,DALL·E可能会出错,而GPT-4o能够正确区分颜色和形状并绘制出来 。总体而言,GPT-4o在文本融入和复杂指令遵循方面的进步,直接体现了架构演进带来的实用性提升。

• 新功能与扩展能力: GPT-4o还引入了一些此前DALL·E系列未具备的新特性。其中之一是图像输入与编辑功能:GPT-4o能够将已有图像作为输入,加以修改后输出新图像 。这意味着用户可以让GPT-4o对一张图片进行再创作,例如风格转换、局部编辑等。这一能力在DALL·E 3中并未公开提供(DALL·E 2提供过Inpainting/Outpainting接口但集成度有限),而GPT-4o将其作为原生能力,展现出向通用多模态转化器迈进的趋势 。另外,GPT-4o生成照片级逼真图像的能力也有显著提升 。DALL·E 2/3虽能生成艺术插画风格的内容,但在逼真人脸和现实场景上往往有所欠缺且容易出错。GPT-4o由于结合了更大的模型和新训练方法(包括人类反馈微调),在许多示例中达到了接近照片的逼真度,同时人物的面部、肢体等细节也更加正确 。当然,模型在这方面仍有局限,例如某些生成的人脸可能过于「完美」而略显假拟,或者在非常小的文字和非拉丁字符上依然会出现失真 。总体来看,GPT-4o相较前代的演进,不仅体现在架构和训练范式的变化上,也通过功能集的扩展拓宽了AI图像生成的应用边界。

综上所述,OpenAI的 4o 图像生成模型在架构上采用了与以往DALL·E扩散模型截然不同的自回归多模态策略。官方信息表明其深度融合于GPT-4o模型内部,通过顺序生成图像token来实现对视觉的精确控制 。社区专家则提供了更细致的推测,认为其内部可能包含自回归先验和扩散/VAE解码相结合的混合架构,以兼顾生成质量与模型集成 。这种架构演进直接带来了模型能力的飞跃:与DALL·E 2和DALL·E 3相比,GPT-4o在文字渲染、复杂场景理解、多轮交互以及图像真实感等方面均有显著提升 。可以说,GPT-4o模型的推出代表了AI图像生成从「跨模态协作」走向「多模态合一」的重要里程碑,它融合了大型语言模型的知识与推理优势,开创了图像生成技术的新路径。今后,随着这一架构的完善和开源社区的跟进,我们有望看到更多类似GPT-4o的多模态生成模型,将AI创作推向新的高度。

参考:

1. OpenAI官方博客: Introducing 4o Image Generation

2. OpenAI系统卡附录: Addendum to GPT-4o System Card: 4o image generation

3. The Verge 科技媒体报道: OpenAI rolls out image generation powered by GPT-4o to ChatGPT

4. Visla 技术博客: What GPT-4o Image Generation Means for Business Creators

5. Hacker News 讨论帖: 4o Image Generation

6. Reddit 论坛讨论: [D] GPT-4o image generation and editing - how???

7. Futurism 新闻报道: OpenAI’s New Image Generator Can Do Near-Perfect Text